T’as déjà vu un robot doué de compassion ?

Une voiture sans conducteur doit-elle sauver la vie de son passager, ou celle d’un passant ? Doit-elle épargner les vies de cinq personnes ou celle d’un enfant ? Les intelligences artificielles intègrent progressivement nos quotidiens. Que doivent-elles intégrer de nos principes ? Il ne devrait pas se passer plus d’une décennie avant que les voitures sans conducteur soient démocratisées.

Dans la revue Science parue le 23 juin dernier, un groupe de psychologue et d’ingénieurs informatique exposent les résultats d’une étude menée sur le sujet. Elle démontre qu’une grande partie des personnes interrogées déclarent vouloir une voiture autonome qui les protègent, eux et leur famille, avant tout. Au détriment d’un piéton, par exemple.

Quelle morale pour les robots ?

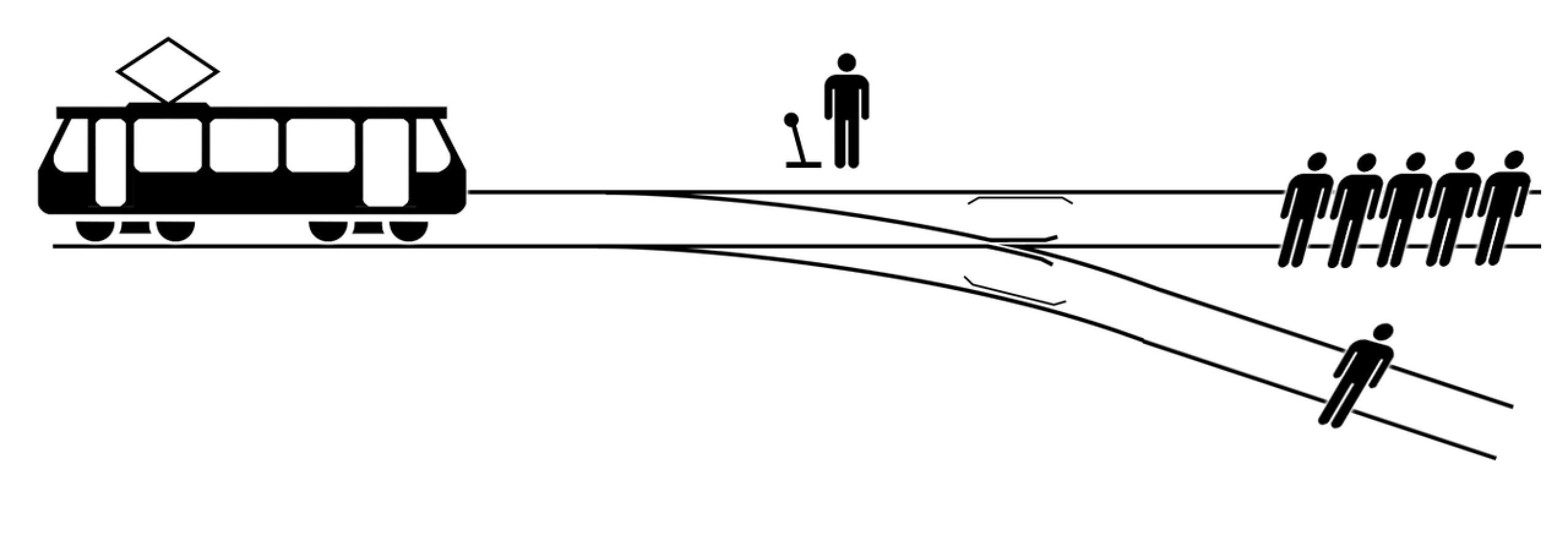

Comme le rappelle le New York Times, le thème de la morale face à la technologie est récurrente dans la science-fiction. Ces problématiques philosophiques sont automatiquement mises sur le tapis lorsqu’on parle de déléguer des actions humaines à des machines. Comment programmer des décisions morales sur des IA, alors que ces questions divisent l’Humanité elle-même ? Dans The Atlantic, le psychologue de Harvard Josua Greene rappelle l’importance du « dilemme du tramway », une expérience de pensée, utilisée en neuroéthique depuis 1967.

Imaginez : un wagon fou dévalant des rails en direction d’un groupe de cinq personnes, qui risquent toutes la mort. Maintenant, imaginez que vous avez la possibilité de dévier le wagon avant l’impact, pour lui faire prendre une voie sur laquelle il n’y a qu’une seule personne. Vaut-il mieux ne rien faire et laisser mourir cinq personnes ? Ou agir et provoquer un seul décès ? Il n’y a aucune bonne réponse à ce test. Un peu comme l’expérience de Milgram, elle permet de déterminer les comportements humains.

Joshua Greene a proposé une variante de ce test. Vous êtes sur un pont, vous voyez un wagon dévaler des rails en direction de cinq personnes. À côté de vous, une très grosse personne. (C’est un vrai test, pas une mauvaise blague, promis.) Si vous la jetez sur les rails, elle arrête le wagon. Que faites-vous ? Lors d’une conférence, le psychologue s’amusait à dire que seuls les psychopathes et les économistes choisiraient de pousser la personne sur les rails. C’était sans compter sur les moines bouddhistes.

« Bouddha pousserait-il l’homme du pont ? »

C’est ainsi que Xin Xiang, un doctorant chinois a intitulé sa thèse, pour laquelle il a soumis des Tibétains, des Chinois et des Américains à cette variante du dilemme du tramway. À la surprise générale, les moines bouddhistes se sont montrés bien plus enclins que les autres à pousser l’homme du pont, faisant ainsi un choix similaire à celui des psychopathes cliniques, et à des personnes souffrant de maladies mentales. La raison : « Bien sûr qu’il est terrible de tuer quelqu’un. Mais si votre intention est pure et que vous le faites pour le bien commun, que vous ne le faites pas pour sauver votre vie, ni celle de votre famille, cela peut se justifier. » Selon cette logique, si elle est inculquée aux AI dans le cas des voitures autonomes, cela pourrait signifier qu’un véhicule choisisse de sacrifier ses passagers pour sauver d’autres vies sur les routes.

« Si l’on considère que le rôle d’une intelligence artificielle est de remplacer une personne, argumente le sociologue Amitai Etzioni dans le New York Times, Il faut inculquer une forme d’éthique à la voiture. » Encore faudrait-il définir une éthique claire, propre à l’humanité. Ou faire confiance aux moines bouddhistes.

Visuel (c) Doomsday Book